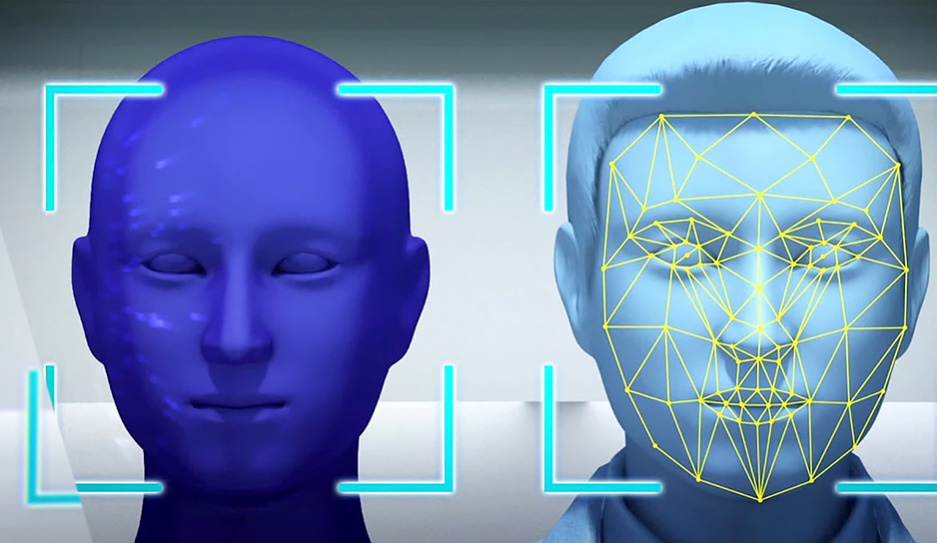

Возможности искусственного интеллекта все чаще используют в грязных политических играх - оклеветать оппонента и вложить ему в уста то, чего он никогда не говорил. Качество дипфейков выходит на новый уровень. Сфабрикованное видео с заявлениями политиков и общественных деятелей уже сегодня практически невозможно отличить от оригинала. Для чего их делают и как не стать жертвой мошенников? Подробности рассказал Андрей Сыч.

Танцующая королева разорвала интернет в 2020 году. Альтернативное поздравление от монаршей особы собрало в совокупности более 100 млн просмотров. "Вау-эффект" от увиденного вызвал у пользователей непреодолимое желание поделиться этим с родственниками и друзьями. При этом создатели дипфейка сделали работу достаточно небрежно и все понимали, что перед ними подделка. В этом и заключалась задумка авторов - продемонстрировать возможность современных технологий в создании дипфейков.

Впервые о дипфейках заговорили еще в 2017 году. Любители контента с пометкой 18+ использовали нейросеть для изменения внешности актеров в порнороликах на лица голливудских звезд. Развитие технологий позволило минимизировать участие человека в этом процессе, и теперь любой пользователь, даже с одной свободной рукой, может создавать подобный контент. Пока специфическое творчество было направлено на удовлетворение индивидуальных потребностей, оно не несло никаких проблем, кроме кровавых мозолей.

Сегодня ІТ-аналитики уверены, что технология дипфейка может стать самой опасной в цифровой сфере за последние десятилетия. Фактически с ее помощью можно полностью уничтожить имидж любого политика, формируя абсурдные заявления, которые в реальности он не делал. Дипфейки уже активно используют в российско-украинском конфликте. Недавно интернет облетело фейковое обращение Владимира Путина.

С каждым разом отличить оригинал от дипфейка становится все сложнее. Только всматриваясь в качественную подделку можно невербально заподозрить вмешательство по отдельным фрагментам мимики. Вот только уделить время этому процессу, как правило, не позволяет тот самый "вау-эффект", а переполняющие эмоции требуют незамедлительно поделиться увиденным. Так произошло и с фейковым обращением Залужного, которое завирусилось на просторах украинского интернета.

Нейросети способны подделывать не только визуальный контент. Машинное обучение позволило достичь практически идентичных голосовых интонаций. Отличить услышанную подделку порой не способны даже близкие люди. Технология активно используется телефонными мошенниками для выманивания денег у родственников под предлогом экстренной ситуации, на которую необходимы непредвиденные траты. Представители CNN провели эксперимент, в ходе которого мама журналиста отвечала на сгенерированные фразы, звучащие голосом сына.

Нейросети с массовым публичным доступом способны на гораздо большие технологичные дипфейки. При создании подделки можно переводить голос на иностранные языки с сохранением оригинального произношения.

Объектом для своеобразной атаки стал и Александр Лукашенко, о чем Президент Беларуси рассказал на встрече с молодежью 25 октября 2023 года: "Нейросети очень меняют общество. Нас ждут в связи с этим тяжелые времена. Нам придется молодняк, пионерию научить пользоваться этими гаджетами, основанными на искусственном интеллекте, на этих нейросетях, потому что появляются такие фейки - человека копируют. Я себя видел (у меня же тоже сидит айтишник под боком), и мне часто говорит: "На, посмотри на себя. Вот ты на французском языке выступаешь". Кто-то знает (в мире или в Беларуси), что я вообще не разговариваю на французском языке. Слушают, в уста могут вложить любую заразу. И люди посмотрят и подумают: "А это наш президент или не наш?" То есть эта штука сильно влияет на мир, на взаимоотношения людей. И тут нам надо быть очень осторожными. Избежать мы этого не можем", - рассказал Президент.

Эпоха постправды стала частью пространства, где каждый из нас зачастую проводит внушительный отрезок своего времени. Важно помнить, что если публикация вызывает у вас "вау-эффект" и эмоции начинают переполнять, то, скорее всего, вами манипулируют.

Читайте также:

-

Телеканал "Беларусь 3" покажет выступления кандидатов в депутаты Палаты представителей

-

По инициативе БРСМ стартовал молодежный информационно-просветительский проект "Паштоўка.БЕЛ"